- 니케이로보틱스_2018/12_AI 딥러닝에 의한 정리정돈 로봇 시스템NIKKEI Robotics

-

- 저자 : 日経テクノロジーオンライン

- 발행일 : 20181110

- 페이지수/크기 : 33page/28cm

요약

Nikkei Robotics_2018. 12 AI 최전선 (p32~34)

AI 최전선

AI 딥러닝에 의한 정리정돈 로봇 시스템

고(高)정밀도 물체 인식을 통해 최초로 정리정돈이 가능

로봇을 사용해 가사일을 해결하고 싶다는 것은 오래 전부터 존재했던 테마이다. 예를 들어 2008년에 미국 스탠포드 대학이 실시한 실험에서는 로봇의 PR1을 사람이 원격 조작함으로써 냉장고를 열어 맥주를 꺼내 뚜껑을 따서 사람에게 건네고 바닥에 어지럽혀져 있는 장난감을 치우거나 식기 세척기에 접시를 넣는 등의 다양한 업무를 해내는 것을 선보였다. 이 실험을 통해 가사일을 해결하기 위한 하드웨어 환경은 이미 갖춰져 있으므로, 나머지는 사람이 원격 조작함으로써 알게 된 부분, 다시 말해, 환경을 인식해 그것에 따라 로봇을 적절히 제어하는 것만 가능하다면 로봇에 의한 가사일은 해결될 것으로 판단된다.

Preferred Networks는 CEATEC JAPAN 2018에서 ‘전자동 정리정돈 로봇 시스템’을 전시했다. 이 전시에서는 도요타 자동차가 개발해 연구개발용으로 제공하고 있는 생활지원 로봇인 HSR(Human Support Robot)을 사용해 로봇이 방 바닥을 정리정돈 하는 시연을 선보였다. 일반 가정의 방바닥에 정리 대상 아이템이 랜덤으로 어지럽혀져 있고 로봇이 그것들을 지정한 장소에 정리정돈 하는 것이다. 가구는 모두 실물이며 정리정돈의 대상 아이템은 일상 생활에서 흔히 볼 수 있는 것 중에서 약 100종류를 선별하고 있다. 미션은 로봇이 그것들의 아이템을 인식하고 파악, 떨어뜨리지 않고 운반해 물체의 종류별로 지정된 장소 및 지정된 상태로 정리정돈을 하는 것이다.

뿐만 아니라, 로봇에 대해 언어나 제스처를 사용해 어디로 치우는 지를 지시할 수 있다. 지시 내용을 파악하기 위해 음성인식 및 사람의 자세 인식을 실시하고 있다. 로봇은 모든 물체가 어디에 있는지를 파악하고 있기 때문에 사람이 찾고 있는 것이 어디에 있는 지를 로봇에게 물어보면 “양말은 현관의 나무 쌓기 블록 옆에 있습니다”와 같은 응답을 해 준다. 이와 같이 현실 세계의 환경이 디지털화되어 컴퓨터로 처리할 수 있게 됨으로써 앞으로 다양한 서비스가 창출될 것으로 예상된다.

이 로봇으로 한 개의 물체를 정리하기 위해서는 대략 30초에서 1분이 걸리며 어지럽혀져 있는 방은 1시간 정도 만에 치울 수 있다. 4일간의 CEATEC 개최기간 중, 2대의 로봇이 정리한 아이템의 총 개수는 약 5,000개에 달하며 그 동안 정기적인 배터리 교환 및 수 회 일어난 물체가 말려 들어가는 것을 제외하고는 거의 사람이 개입하지 않고도 안정적으로 작동을 지속할 수 있었다.

이 개발에는 데이터 수집을 비롯해 반 년 정도의 기간이 소요되었으며 기간 중 평균적으로 20명 정도가 참여했다. 지금부터는 이 전시에서 사용된 기술에 대해 소개하겠다.

데모 시스템은 처음에 4대의 천정 카메라를 사용해 방 안의 어느 위치에 어느 물체가 있는 지를 인식한다. 천정 카메라 없이도 로봇이 치울 수 있지만, 그럴 경우 로봇은 처음 시작할 때 방안을 둘러보고 어느 아이템이 어디에 있는 지를 파악할 필요가 있다. 이번에는 시연회의 신속한 진행을 위해 천정의 카메라를 이용했다.

그 다음으로, 로봇이 어느 물체를 가지러 가는 지를 플래너가 결정한다. 이번 전시에서는 가장 가까이 있는 것을 가지러 간다는 단순한 전략을 채택했으나, 중요도가 높은 것부터 치우는 것과 같이 다양한 요구에 부응한 플랜을 만드는 것도 가능하다. 그 이후에는 HSR에 구비되어있는 카메라를 사용해 물체를 인식해 그 물체의 종류 및 위치, 파지(grasping) 할 위치를 추정한다. 이 인식 결과에 따라 로봇은 물체를 파악해 정리할 위치로 가져가 적절한 위치에 놓는다.

-- 세계 2위의 성적을 낸 심층 학습 모델을 이용 --

이번에 특히 어려웠던 것은 물체 인식과 파지(grasping) 계획이다. 다루는 물체의 종류가 약 100종류로 상당히 많으며 놓여 있는 방식도 다양하다. 대상 물체도 수건이나 양말 등 형태가 일정하지 않은 것도 많다. 이는 아이템을 검출하는 것 자체가 어려울 뿐 아니라, 그 물체의 형상 및 자세를 추정하는 것도 힘들다. 검출 위치도 높은 정밀도가 요구되어 파지 위치가 수cm 어긋나는 것 만으로도 물체를 집을 수 없게 된다. 파지 위치도 한정되어 있어 장난감 물뿌리개나 죽방울 등은 정확한 파지 위치의 선택 폭이 조금밖에 없다.

이런 물체 인식에 딥러닝에 의한 화상 인식기를 이용했다. 화상 인식은 ImageNet으로 사람의 인식 정밀도를 뛰어넘은 후에도 경이적인 향상을 지속하고 있다. 이번 데모 시스템에 이용된 화상 인식은 Preferred Networks가 Google AI Open Images Challenge 2018에 출전한 세계 2위의 성적을 거뒀을 때 사용했던 PFDet을 확장한 모델을 이용하고 있으며 100대가 넘는 GPU를 이용해 학습하고 있다. 훈련 데이터는 실제 사람이 살고 있는 것과 같은 방을 만들어 다양한 일용품을 배치해 사진 촬영을 통해 작성했다.

이와 같이 학습된 모델은 높은 인식 정밀도와 환경 변화로의 로버스트성(Robust power)을 달성해 이번 과제 실현의 중심적인 역할을 해냈다. 인상적인 사례로는, 전시 기간 중에 조명이 꺼지는 트러블이 발생해 촬영 환경이 크게 변화했을 때에도 데모는 멈추지 않고 계속되었으며 로봇은 정확하고 지속적으로 정리정돈을 할 수 있었다는 것이다. 화상 인식의 추론은 로봇과는 별도의 전시 부스 제어실에 설치되어 외부 CPU가 장착된 서버로 실행해, 1초간 2~3장의 화상을 추론하는 것이 가능했다. 앞으로는 로봇에 탑재한 칩에서 추론할 수 있게 될 전망이다.

-- 음성 및 제스처 등으로 지시 가능 --

로봇에게는 음성으로 지시를 내리는 것이 가능해, 이번 실현을 위한 음성 인식은 전시회장의 노이즈에 대처할 수 있는 연구를 실시하고 있다. 또한 이번 문제 설정에 맞춰 대상 물체 및 지시에 특화된 언어 모델의 최적화를 시행하고 있다.

유저는 음성으로 어떤 부분을 치우면 좋을 지, 물체를 어디로 옮기면 좋을 지, 물체가 어디에 있는 지에 관한 지시를 내릴 수 있다. 이 지시는 로봇이 동작하는 중에도 시행할 수 있으며 몇 번이나 반복할 수 있다. 로봇에게 한 지시가 실패해도 바로 반복 지시를 통해 인식할 수 있게 만들어져 있다. 이와 같은 지시를 반복함으로써 인식 정밀도가 100%에 달하지 않아도 이용자가 스트레스를 받지 않고 지시를 내릴 수 있게 설정되어 있다. 이와 같이 로봇을 음성으로 지시하는 기술에 대해서는 다른 논문도 참고하기 바란다.

제스처를 통한 지시도 가능하다. 장소의 지정 등 언어 만으로는 지시가 어려운 경우(책상의 특정 다리 근처 등을 가리킬 때)나 이름을 모르는 물체에 대해 지시를 내릴 때는 제스처를 사용하는 것이 빠를 것이다. 이번 데모에서는 제스처의 인식에 있어서 천정 부근에 구비된 거리 화상 센서(Kinect)를 이용하고 있으나, 앞으로는 로봇에 구비된 카메라로 인식하게 될 것이다.

로봇을 이용할 경우, 로봇이 무슨 생각을 하고 있는 지 알 수 없으며 지시가 명확하게 전달이 되었는지 알 수 없다는 문제점이 있었다. 이번에는 AR기술을 사용해 로봇이 무엇을 생각하고 있는지를 보여주는 데모를 시행했다. 이것에 의해 로봇이 어느 물체를 어떻게 인식하고 있는지, 로봇이 무엇을 생각하고 있는지를 직감적으로 이해할 수 있었다.

이렇게 눈에 보이는 기능 외에도, 이번 시스템 개발에는 다수의 기술이 투입되고 있다. 예를 들어, 전시회장은 전파 간섭이 강하기 때문에 로봇이 안정적으로 외부 서버와 통신될 수 있게 무선 네트워크 준비에 많은 노력을 기울였다. 또한 많은 서브 시스템이 연결된 상태였지만, 개발 스피드를 떨어뜨리지 않기 위해 테스트 자동화 등 CI(계속적 인테그레이션)의 실현에 많은 개발 리소스를 할애하고 있다.

-- 과제와 전망 --

이번의 로봇에 의한 자동 정리를 일반 가정에서 실용화하기 위해서는 아직 기술적인 과제가 남아 있다. 파지에 관해서는 보다 많은 종류에 대응할 필요가 있으며 특히 대형의 의류 및 수건, 센서가 잘 읽어내지 못하는 투명한 패트병, 미묘한 힘 조절이 필요한 유리 제품 등을 안정적으로 파지할 수 있는 것이 요구된다. 이번에는 HSR에 표준 탑재되어 있는 평행 그립퍼와 흡착용 핸드를 이용했으나, 대응 물체를 늘리기 위해서는 새로운 기구 및 센서도 필요해질 전망이다.

또한, 방의 환경도 다양한 상황에 대응할 필요가 있다. 바닥의 높낮이 및 카펫이 있을 경우의 대응, 환경이나 빛의 밝기가 달라져도 안정적으로 대응할 구 있는 물체 인식이 필요하다. 또한 방이나 집 안의 정확한 지도 정보가 미리 확보되지 않아도 이와 같은 시스템 구축이 바람직하다.

언어나 제스처에 의한 지시도, 방 안의 다양성을 커버할 수 있도록 보다 표현력을 늘리는 것이 요구되고 있다. 정리하는 것에 그치지 않고 가사일도 로봇으로 해결해 갈 수 있을 것이다. 집을 치우는 것과 같은 기술을 필요로 하는 업무는 해결될 수 있겠지만(특정의 물체를 특정의 장소로 운반해 물체를 수집하는 등), 도구를 사용할 경우나 사물을 가공하는 것(예를 들어 종이 박스를 개봉하는 등)과 같은 업무는 난이도가 크게 높아진다. 그러나 앞에서 거론한 실험에서도 나와 있는 것처럼 다른 업무도 사람이 원격 조작만 한다면 해결될 수 있기 때문에 이것을 자동화하는 것은 불가능한 일이 아닐 것이다.

-- 끝 --

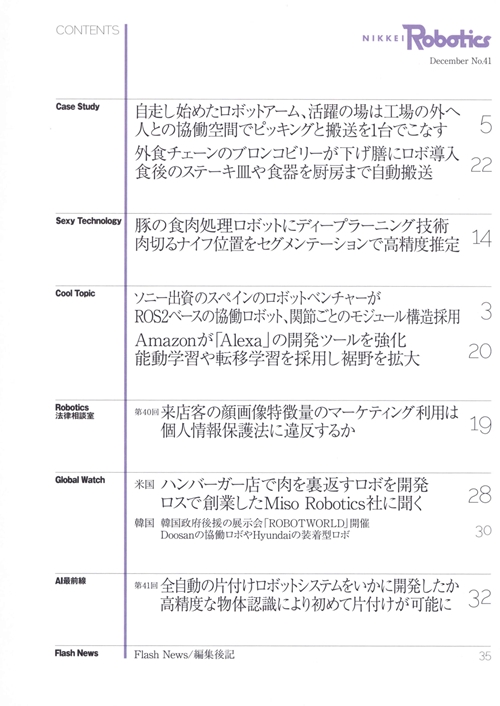

목차